RTC技术是实时AI普及的关键之一。

作者 | ray

编辑 | 静宇

她正在从电影走向现实。

今年5月,最新的AI多模态模型GPT-4o发布。与上一代GPT-4 Turbo相比,GPT-4o速度提升一倍,成本降低一半。实时AI语音交互的平均延迟比上一代GPT-4 Turbo降低了100%,相比之前版本的2.8秒(GPT-3.5)到5.4秒(GPT-4),达到了320毫秒——几乎与日常人类对话的响应速度相同。

除了提升效率,对话过程中的情绪分析也成为本次产品更新的功能之一,在与主持人的对话中,AI能够听出他讲话时的“紧张情绪”,并特意提出深呼吸的建议。

中芯国际,正在成为大模型时代硅基的“创造者”。

然而发布会很轰动,现实却很惨淡,到了产品发布的时候,这家大型模型技术革命的发起者,却渐渐变得像是一家“期货”公司。

主打全方位、低延迟的GPT-4o发布后,实时音视频功能的推出至今一直被推迟;视频多模态产品Sora的发布也被推迟。

但这不仅仅是一家公司的问题,发布之后,国内也出现了不少版本,但GPT-4o真正的竞争对手只有一个,就是商汤科技的 5.5,而且其进度也是在每月一次的内部公测中。

为什么在发布会上,实时多模大模型距离改变世界只有一步之遥;但在真正走向产品化的过程中,却总是从“点”变成“选项”?

一种新的声音正在出现:在多模式世界里,也许(算法)暴力没有奇迹。

01

实时语音,一

AI商业化的必由之路

技术的成熟,正在助力一个全新的蓝海产业形成。

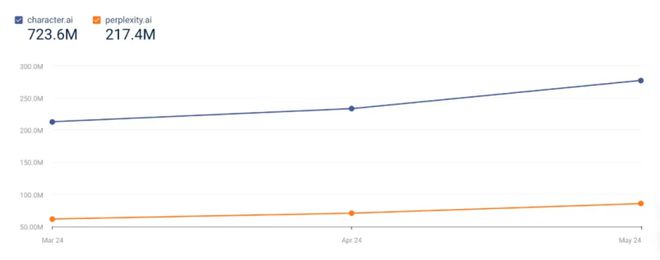

硅谷知名创投公司a16z的数据显示,全球排名前50的AI应用中,有9个是陪伴型产品。AI产品排行榜数据显示,今年5月AI陪伴型产品的访问量达4.32亿次,同比增长13.87%。

高需求、高增长率、大市场空间,伴随着人工智能,带来商业模式和人机交互的双重变革。

业务的成熟也在倒逼技术的不断进步,仅今年上半年,实时AI语音技术在短短半年内已经历了三次迭代。

第一波技术的代表产品是Pi。

今年 3 月, AI 更新了 Pi,这是一款面向个人用户的情感聊天机器人。

Pi的产品界面非常简洁,文字+对话框是核心的交互界面,但也加入了语音朗读、电话等AI语音功能的设计。

为了实现这种语音交互,Pi 依靠的是 STT(语音识别,-to-text)-LLM(大模型语义分析)-TTS(文本转语音,Text To)的传统三步语音技术,其特点是技术成熟,但反应较慢,缺乏对语气等关键信息的理解,无法实现真正的实时语音对话。

同期发布的另一款主打产品是 Call Annie,相比 Pi,Call Annie 拥有完整的视频通话体验设计,除了接听、挂断电话的设计外,聆听功能可以最小化然后切入其他 App,并支持四十余个对话角色设定。

但它们都存在着共同的技术问题——延迟高、缺乏情感色彩。延迟方面,即便是业内最先进的也会有2.8秒(GPT-3.5)到5.4秒(GPT-4)的延迟。情感方面,交互过程中会丢失声调、音调、语速等信息,无法输出笑声、歌声等高级语音表情。

在此之后,新一波技术代表的是一款名为EVI的产品。

这款产品由Hume AI于今年4月推出,并为Hume AI带来5000万美元(约合人民币3.62亿元)的B轮融资。

在产品设计方面,休谟AI在底层算法环节上线了功能,用户可以自行选择配置,选择大模型,除了官方默认的,还可以选择,比如GPT-4 Turbo。但不同的是,语音是有情绪的,所以在表达上,也有节奏、语调的变化。

而要实现这个功能,我们主要依靠在传统的STT-LLM-TTS三步流程上加入新的SST(space,语义空间理论)算法,SST能够精准绘制出人类情绪的全光谱,揭示出人类情绪状态之间的连续性,赋予EVI许多拟人化的特征。

情感进步的代价是延迟的进一步牺牲,与EVI对话时,用户需要等待的时间相比Pi和Call Annie进一步增加。

5月中旬,GPT-4o发布,多模态技术的融合成为这一时期的技术方向。

相比之前的三步语音交互产品,GPT-4o 是一个跨文本、视觉和音频端到端训练的新模型,这意味着所有的输入和输出都由同一个神经网络处理。

延迟问题得到了很大改善,官方称 GPT-4o 的实时语音交互对音频输入的响应时间最高为 232 毫秒,平均为 320 毫秒;情感上,用户与 AI 的交互也变得更加智能化,语速更快,能够实现更多的情感理解。

在产品层面最准一肖一.100%准,人类爱上AI成为可能,AI也可以代替盲人看世界。

近期推出语音通话功能的硅谷2024新星.ai,成为这波科技浪潮的最大受益者。

在.ai中,用户有机会以超现实的角色扮演方式与动漫人物、电视名人和历史人物进行文字交流。新颖的设定带来了产品用户数量的激增。数据显示,.ai每秒拥有1亿用户。它可以处理2万个AI推理请求,5月份的访问量达到2.77亿次。

.ai与.ai流量对比|

与此同时,微软、谷歌等公司已正式宣布其大屏机型将推出实时语音通话功能。

但滴水不漏的产品设计在实际实施中始终呈现出三峡大坝泄洪的效果,在第三波中,发布会上那些几乎“她”字样的随行产品,全部变成了“计划中”“即将上市”“内测中”。

一个不能过分强调的结论是,实时音视频或将成为人机交互的终极形态。除了AI陪伴场景,游戏智能NPC、AI口语老师、实时翻译等场景都有望爆发。但在此之前,如何实现实时音视频?解决从“发布会”到产品发布的最后一公里,是当今业界最难攻克的难题。

02

AI实时语音,

没有实力就没有奇迹

AI实时语音 “付出再多的努力也创造不了奇迹”,一句悲观的说法正在硅谷悄然流传。

阻力来自技术、法规和商业等各个方面。

技术反对派的精神领袖是“卷积网络之父”Yann LeCun。

在他看来,大模型技术相比过去各类AI算法,最大的特点是能够以大力量创造奇迹,通过喂给大数据、上亿的参数以及高性能计算集群的硬件支持,算法可以处理更复杂的问题,扩展性更高。但目前大家对大模型过于乐观,尤其是认为多模态大模型可能是世界模型的观点,是无稽之谈。

比如人有五感,构成了我们对世界的真实认知,而基于大量互联网文本训练出来的LLM,缺乏对物理世界的观察和交互,缺乏足够的常识,因此在生成视频或者语音的过程中,会出现看似天衣无缝的内容、动作轨迹,或者声音情绪,但缺乏真实感。另外,硬性的物理限制也是一个问题,面对不断增长的模型规模和交互维度,目前的大模型缺乏足够的带宽来处理这样的信息。

在监管层面,AI实时语音,也就是端到端的语音模型,面临着技术与伦理的博弈。

过去,传统AI语音行业有三个步骤:STT-LLM-TTS。第一是由于技术的不成熟,向端到端的语音模型演进需要在模型架构、训练方法、多模态交互等方面付出额外的努力。同时由于语音比文本更难监管,AI语音很容易被用在电话诈骗、色情、垃圾营销等场景。为了方便审核,中间的文本环节也变得更加必要。

在商业层面,端到端的音视频模型训练在训练阶段需要大量的播客数据,成本是过去文本训练模型的几十倍甚至更高,单次训练成本动辄数千万美元起。

对于此时的普通AI公司来说,这种成本就算天上掉钱也没用,还要花钱购买的高端AI计算卡、千兆存储,以及取之不尽的无风险音视频版权。

当然,无论是杨立坤的技术判断,还是可能面临的监管困难,亦或是商业化的成本困境,这些都不是Open AI最核心的问题。

GPT-4o等实时AI语音交互产品之所以能从现货走向期货,根本原因在于工程实现层面。

03

GPT-4o 演示了插入网线的情况。

仍然需要良好的 RTC 辅助

业界一个不为人知的秘密是,类似GPT-4o的AI实时语音产品在工程层面只成功了一半。

在GPT-4o的发布会上,在宣称低延迟的同时,有眼尖的用户注意到演示视频中的手机还插着网线,这意味着GPT-4o官方公布的320ms平均延迟很可能是一个固定设备、固定网络、固定场景的演示,是理想条件下才能达到的实验室指标。

GPT-4o 发布会上手机插件清晰可见 |

哪里有问题?

从技术层面来看,要实现AI实时语音通话,算法层面的三个步骤合并为一步,这只是核心环节之一,另一个核心环节RTC通讯层面也面临一系列的技术挑战,所谓RTC可以简单理解为实时网络环境下音视频的传输与交互,是支持实时语音、实时视频等交互的技术。

声网音频技术负责人陈若飞告诉极客公园,在实际应用场景中,用户通常不可能一直处于固定设备、固定网络、固定物理环境中,优化之后就会出现语音卡顿、延迟较高的情况。AI实时语音通话中也会出现这种情况,因此低延迟传输和优秀的网络优化对于RTC传输至关重要。

此外,多设备适配、音频信号处理也是AI实时语音实现中不可忽视的技术环节。

如何解决这些问题?

答案就在最新的招聘要求中叙述管家婆一肖一码100正确,GPT-4o 横空出世!速度翻倍、成本减半,实时 AI 语音互动时延仅 320 毫秒,其中特别提到需要招募工程人才来帮助他们将最先进的模型部署到RTC环境中。

在具体方案选择上,GPT-4o采用的RTC技术是基于的开源解决方案,可以在技术层面解决一定的延迟,以及不同网络环境带来的丢包、通信内容安全、跨平台兼容问题。

但是开源的B面是产品化的弱点。

举个简单的例子,多设备适配的问题,RTC的使用场景大多以手机为代表,但是不同型号的手机的通讯和声音采集能力差别很大:目前苹果手机可以做到几十毫秒左右的稳定时延,但生态系统相对复杂,不仅型号繁多,而且高低端产品之间的性能差距也比较明显,对于一些低端机型,在采集和通讯层面的时延可以高达几百毫秒。

例如在AI实时语音应用场景中,人声信号可能会混杂背景噪音,需要进行复杂的信号处理去除噪音和回声,以保证干净、高质量的语音输入,让AI能够更好地理解人类所说的话。

多设备兼容性和高级音频降噪功能正是开源所缺乏的。

行业经验是开源产品应用的一个瓶颈问题,因此相较于开源方案,大型模型厂商与专业的RTC方案提供商共同打磨优化,一定程度上更能代表未来的行业趋势。

在RTC领域,最具代表性的厂商是声网(Agora),它曾因提供音频技术而广为人知,据声网官网消息,全球超过60%的泛娱乐APP都选择了声网的RTC服务,除了国内知名的小米、B站、陌陌、小红书等APP外,还有中东和北非地区最大的语音社交娱乐平台Yalla,东南亚“社交直播平台之王”Kumu,HTC VIVE,The Meet Group,Bunch等全球知名平台均采用了声网的RTC技术。

行业经验的积累和全球客户的打磨是其技术领先的证明。据陈若飞介绍,声网自主研发的SD-RTN™实时传输网络覆盖全球200多个国家和地区,全球端到端音视频平均端到端时延为200ms。针对网络环境波动,声网的智能路由技术和抗弱网算法可以保证通话的稳定和流畅。针对终端设备的差异,声网积累了全球最大的预装数亿级APP,积累了适应复杂环境的know-how。

除了技术领先之外,行业经验也是一道无形的障碍。

其实这也是多年来RTC行业业务格局相对稳定的原因:做好RTC,从来不靠大模式的“大力量创造奇迹”。

只有通过长期的精心耕耘,才能实现语音时延的极致优化,实现实时语音交互的大规模商用。

从这个角度来看,AI实时语音交互是一场想象力和难度都不容小觑的战争。

它的未来——算法、审计、RTC等等,都需要攻克。要走完这条漫漫长路,我们必须仰望技术的天空,脚踏工程的土地。

发表评论